Історично поява нових технологій завжди впливала на характер і методи ведення війни: свого часу залізна дорога й літаки повністю революціонізували військову логістику. Поява ядерної зброї, в свою чергу, кардинально змінила правила гри. Викликом сьогодення ж стали автономні «роботи-вбивці»: чому їх закликають заборонити ще до початку широкого використання та яку роль у цьому відіграють наддержави й приватні компанії?

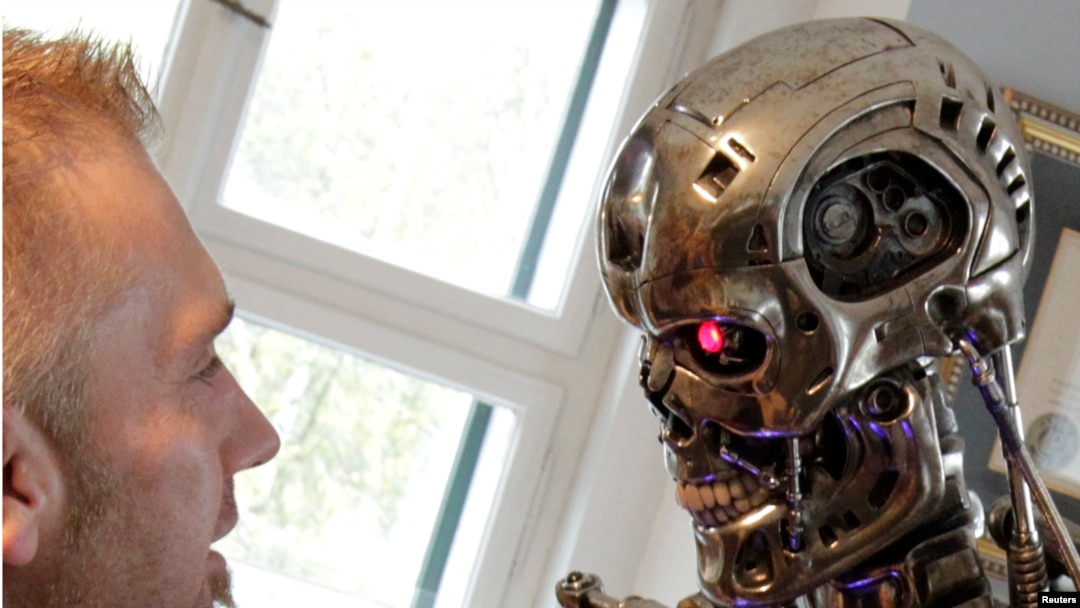

Провідні світові науковці та технологи тривалий час висловлюють занепокоєння останніми тенденціями в розвитку роботобудування й штучного інтелекту. Особливим приводом для занепокоєння є ніщо інше як автономна зброя – роботи, які діють на основі штучного інтелекту й здатні самостійно виконувати військові операції, тобто вирішувати, кого вбивати на полі бою.

Люди, які допомагали в розробці машинного навчання та штучного інтелекту, вже пітніють

«Вам можна пробачити, якщо ви спітніли лише від однієї думки про те, що держави використовують армії роботів, які самі собі вирішують, убивати чи ні. Деякі люди, які допомагали в розробці машинного навчання та штучного інтелекту, вже пітніють», – йдеться в статті журналу Wired.

Такі роботи поки що не беруть участі в сучасних арміях, але з огляду на останні розробки в сфері штучного інтелекту, багато хто вважає, що це лише питання часу. Військова автоматизація загалом не є чимось новим, але сьогодні за нею так чи інакше завжди стоїть людина. Більшість експертів погоджується, що в разі використання летальної зброї залучення людини є просто необхідним, йдеться у новому звіті The Economist, присвяченому революції військової робототехніки.

Discover Magazine: «Забудьте про заборони: ООН «застрягла» на визначенні «роботів-убивць»

«Автономна зброя – скринька Пандори»

Відомий винахідник Ілон Маск, вчений Стівен Хокінг та «батько» Microsoft Білл Ґейтс погоджуються з тим, що в разі неправильного поводження зі штучним інтелектом він може перетворитися на загрозу існуванню людства. Маск разом зі 115 іншими лідерами в сфері штучного інтелекту навіть підписали відкритий лист в ООН, що закликає покласти край гонці озброєння в сфері автономної зброї ще до того, як її використання набуде поширення.

Тільки-но ця скринька Пандори відкриється, і її вже буде складно зачинити

«Ми не маємо багато часу. Тільки-но ця скринька Пандори відкриється, її вже буде складно зачинити», – йшлося в листі.

Низка неурядових організацій заснували «Кампанію зупинки «роботів-вбивць» і активно працюють, щоб зупинити використання автономної летальної зброї.

Жартівливий макет робота під час заснування «Кампанії зупинки «роботів-убивць» у Лондоні, 2013 рік

В чому проблема?

Причин для занепокоєння досить багато. Серед них, наприклад, те, що як і будь-яку комп’ютерну систему, «роботів-убивць» можна буде «зламати» за допомогою кібератак. По-друге, що такі роботи можуть просто вийти з ладу й призвести до масштабної катастрофи.

«Немає ніякої гарантії, що будь-яка технологічна система працюватиме бездоганно. Але коли ви дасте цій системі летальну зброю, небезпека зростає в багато разів», – зазначив науковець Ульрік Франк для Deutsche Welle.

По-третє, в разі порушення гуманітарного права питання полягатиме в тому, хто саме нестиме за це відповідальність, адже робот діятиме самостійно. Більше того, така зброя може потрапити до рук недержавних акторів, включаючи терористичні угруповання.

Основні гравці: інтереси наддержав та приватних компаній

Штучний інтелект сьогодні є надзвичайно важливим компонентом стратегії національної безпеки для наддержав. Не так давно російський президент Володимир Путін заявив про те, що штучний інтелект має колосальний потенціал і що той, хто зможе стати лідером у цій сфері, стане правителем світу. Хоча він і пообіцяв ділитися отриманими знаннями в цій сфері з іншими країнами, багато хто передбачає справжню гонку за передові технології штучного інтелекту.

Багато хто передбачає справжню гонку за передові технології штучного інтелекту

Наприкінці минулого року в Женеві цілий тиждень тривали обговорення використання штучного інтелекту в озброєннях, після чого у виданні Business Insider з’явилася стаття про ігнорування Росією будь-якої заборони ООН на «роботів-убивць». На думку Росії, заборона летальних автономних систем озброєнь «обмежує свободу використання переваг автономних технологій, що є майбутнім людства», мовиться у статті. Але навіть заборони використання певних типів зброї історично не були перешкодою для «поганих хлопців», зауважує автор.

Є також думки, що найбільші амбіції домінувати в індустрії до 2030 року має саме Китай, особливо зважаючи на те, що за три десятиріччя економічного зростання він цілком може собі це дозволити.

Багато хто звертає увагу й на те, що саме приватні компанії стоять за стрімким розвитком автономної зброї. Корпорації зацікавлені в прибутках, і вони активно діятимуть для пришвидшення розвитку цих технологій.

Чим кориснішою буде потенційна зброя для військових, тим важче буде її регулювати або ж заборонити

«Це дилема контролю над озброєннями. Чим кориснішою буде потенційна зброя для військових, тим важче буде її регулювати або ж заборонити», – пояснює Deutsche Welle професор політичних наук в Університеті Пенсильванії Майкл Горовіц.

Нові поля бою та «зброя збентеження»

Автономна зброя – не єдина передбачувана зміна на полі бою, але й самі поля боїв також зазнають певних змін.

За останні роки масштабні кібератаки вже довели свою руйнівну силу, у той час як Агентство ЄС з питань мережевої та інформаційної безпеки в своєму звіті називає саме Росію та Китай «провідними хакерами» світу.

Інтернет і соціальні мережі, тим часом, перетворилися в інструменти маніпуляції думкою громадськості: сучасні технології дозволяють зловмисникам не просто поширювати дезінформацію, але націлювати свою «зброю збентеження» виключно на тих людей, які були б найбільш сприйнятливими до такої інформації. Наслідки дезінформації при цьому можуть бути масштабні, попереджає The Economist.

Скоро нам потрібно буде почати сумніватися в усьому, що ми бачимо й чуємо

З іншого боку, розвиток штучного інтелекту ще більше ускладнюватиме ситуацію з фейковими новинами. «Нам часто казали не вірити всьому, що ми читаємо, але скоро нам потрібно буде почати сумніватися в усьому, що ми бачимо й чуємо», – йдеться у виданні The Guardian.

«Найбільшою втратою, спричиненою штучним інтелектом, стане повне знищення довіри до будь-чого, що ви бачите або чуєте», – пояснює в статті для Wired Вільям Веслер. Він звертає особливу увагу на проблематику відтворення штучним інтелектом не тільки фейкових фото чи відео, але й аудіо, яким наразі вже займається проект Adobe Voco.

Незважаючи на очікувані прибутки від технології, вона може мати вкрай негативні наслідки і навіть призвести до війни, наголошує автор. Заміну голосу можуть почати широко використовувати для того, щоб обдурити чи збити людей з пантелику: «Просто уявіть собі наслідки підробленого голосу світового лідера, який робить войовничі заяви, підкріплені фальсифікованими відео. Чи зможуть у 2018 році громадяни або військові генерали визначити, що це фальшивка?» – запитує Веслер.

«Роботи-вбивці, воля та ілюзія контролю»